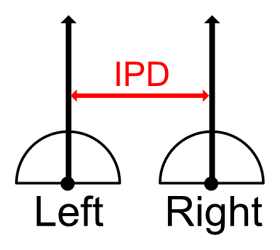

IPDは、一般的には64mmを使用することが多いです。

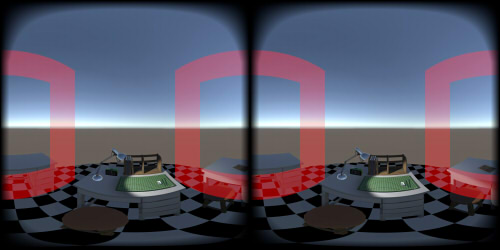

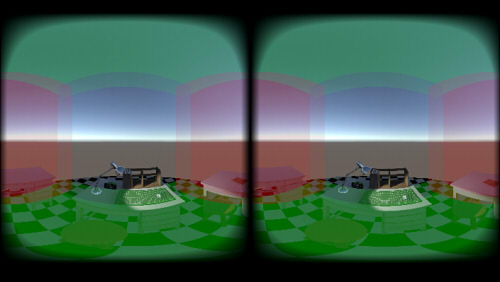

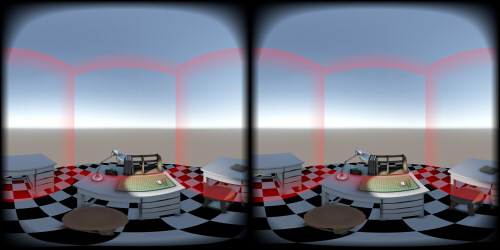

左右の目を模して撮影した魚眼レンズからの映像を左右に並べる、 もしくはEquirectangular形式に変換したものがVR180カメラでよく使われる形式になります。

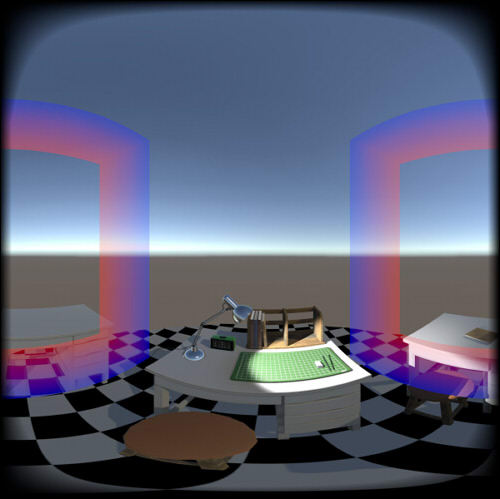

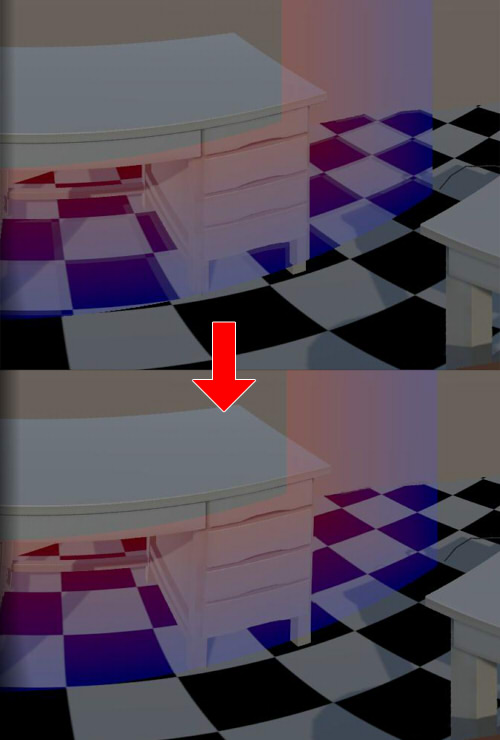

以下は、Equirectangular形式にしたものです。

VR180フォーマットでは、この映像に投影方式や配置方法などの情報を"メタデータ"として与えることになります。

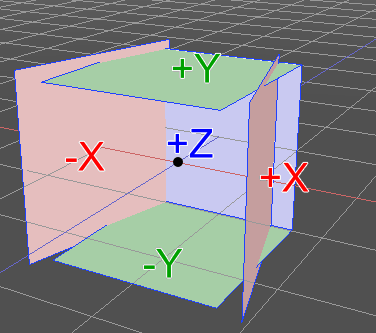

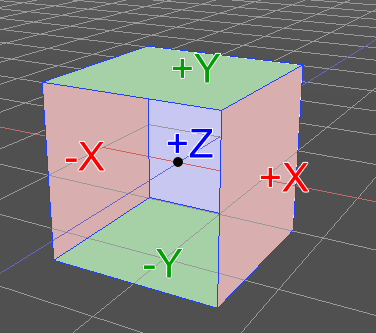

レンダリングでEquirectangular形式の映像を生成するときに、以下のような手順で行いました。

- 左右それぞれで、5つのカメラを配置(+Z/-Y/+Y/-X/+X方向)

- レンダリング時にカメラの中心から半球状に走査し、各カメラの投影面と交差する場合はその色を採用

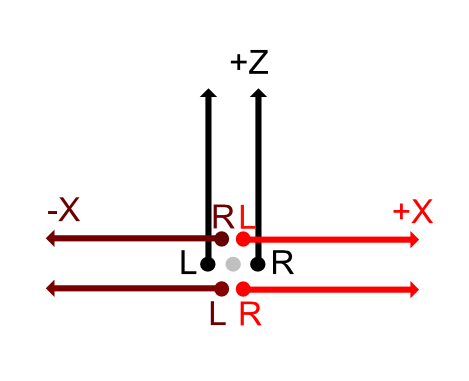

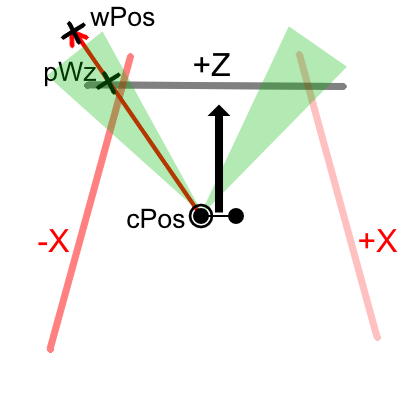

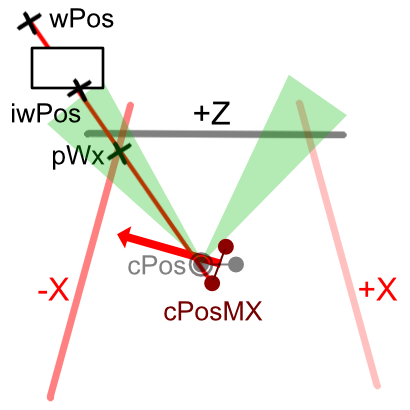

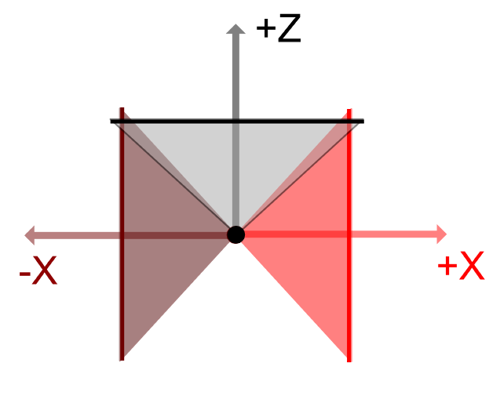

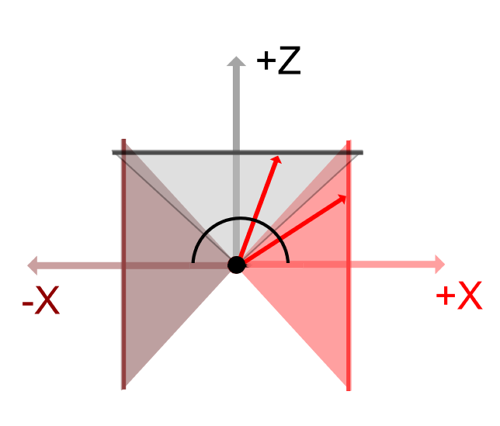

上から見下ろすと以下のようになります。

カメラの中心から+Z/-X/+X方向、-Y/+Y方向を向いた5つのカメラでそれぞれレンダリングします。

カメラから半球状に走査し、カメラの投影面と交差する箇所の色を採用します。

視野角度は90度ではなく95度にし、境界部分が重なる箇所は滑らかに見せるように補正します。

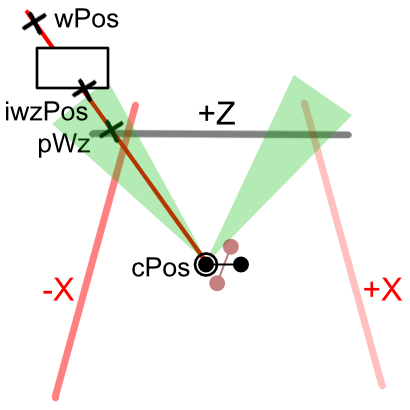

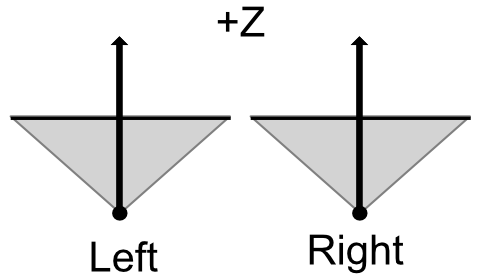

左右の視点を考慮すると、+Z方向は以下のようにIPDの距離だけ離れて平行です。

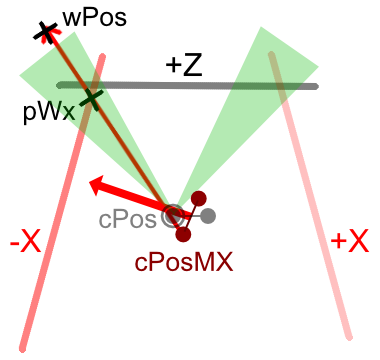

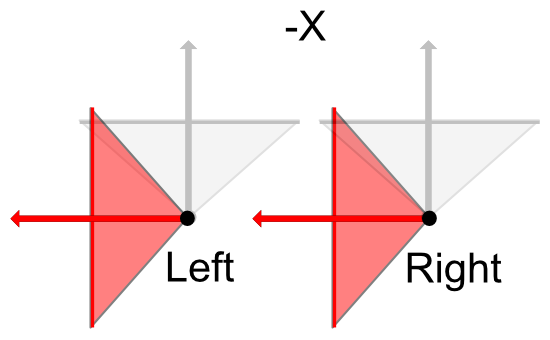

-X方向は、カメラの位置は変わらず-X方向を向きます。

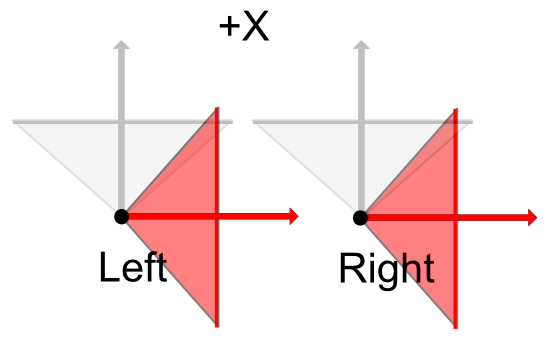

+X方向も同様です。

VR180カメラのようなレンダリングを行う際は、

左右のカメラの中心はどの方向を向いていても、IPDの距離分離れているだけで同じ位置になります。

これより、+Z/-Y/+Y面についてはIPD分の視差が発生しますが、 -X/+X面についてはカメラが互いに前後にずれているだけであるので視差が発生しないのが分かります。

これは立体視としてVRで見た場合に、前面や上下を向いた場合は視差が正しく反映されますが、 左右を向くにつれて視差がなくなる、という現象に結び付きます。

これは、物理的な魚眼レンズ2つのみで撮影する場合でも同様の現象になります。

レンダリング結果は、以下のようにEquirectangular形式になります。

分かりやすいように、-X/+Xを赤色、-Y/+Yを緑色にしています。

このレンダリングの場合は、左右それぞれのカメラ位置が同じであるので 境界部分をスティッチしなくても問題ありません。

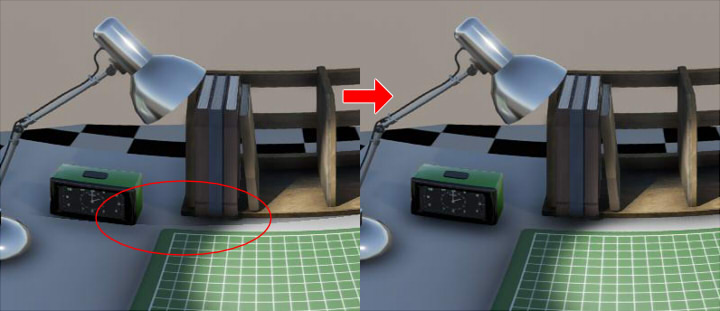

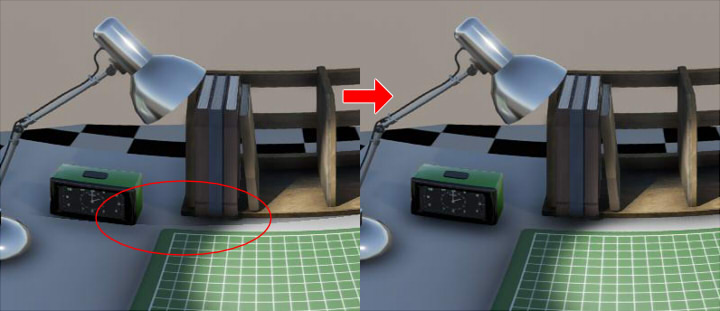

境界部分の補正

キューブマップ面それぞれにPost Processingを割り当てている場合には、

それぞれの面の境界部でつながらない部分が出てきます。

これを緩和するために、境界部分はウエイト値を与えて補正するようにします。

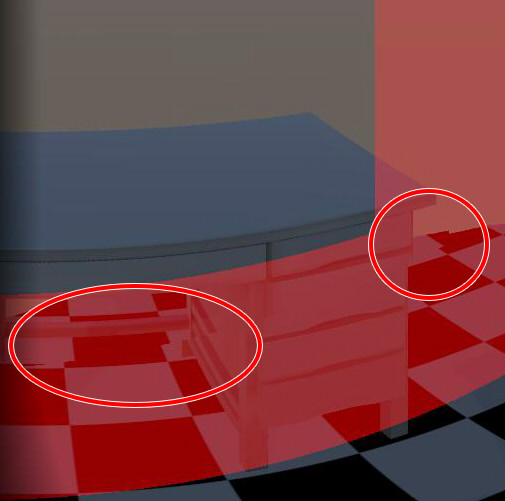

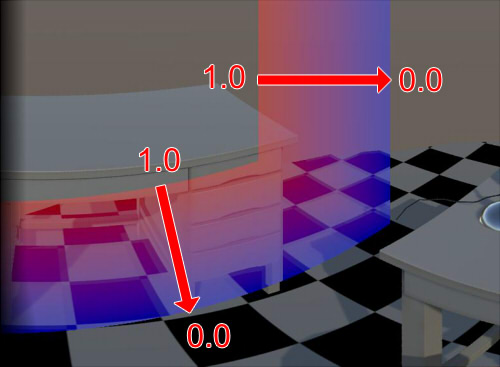

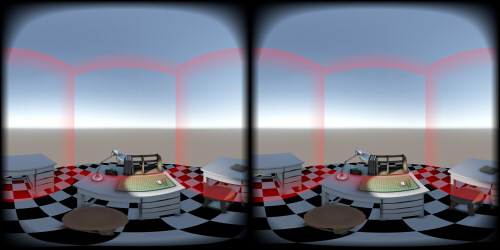

以下は境界部分を赤く可視化したものになります。

境界部は、あらかじめ固定の位置(球投影での角度)を与えています。

単純にキューブマップ面を合成しただけの場合は、 Ambient OcclusionやBloomの影響が大きいときに境界部分の切れ目が見えてしまいます。

これを解決するために、境界部にウエイト値を与えて補間することで境界が目立ちにくいようにします。

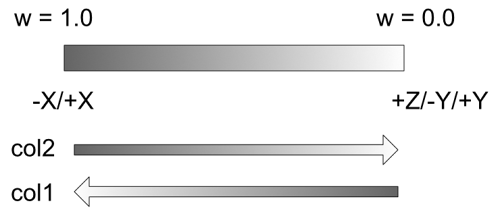

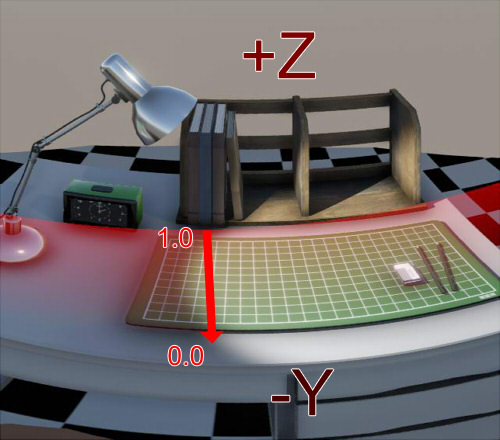

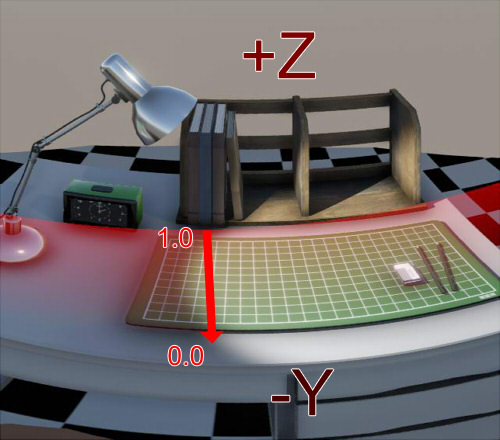

下画像の場合は、境界部分で+Z面に接する箇所はウエイト値が1.0に近づき、 -Y面に接する箇所は0.0に近づきます。

境界でない箇所はウエイト値を0.0としました。

境界部分では、+Z/-Y面がそれぞれ重なる箇所になるため、 +Z面上のピクセル色(col1)と-Y面上のピクセル色(col2)をあらかじめ取得できます。

ウエイト値をwとすると、以下の式で補正します。

この補正は、+Z面に接する-Y/+Y/-X/+X面、

-Y面に接する-X/+X面、+Y面に接する-X/+X面

にそれぞれ境界部を与えて行うことになります。

こうすることで、ある程度のPost Processingの境界部の色差を緩和できます。

これを緩和するために、境界部分はウエイト値を与えて補正するようにします。

以下は境界部分を赤く可視化したものになります。

境界部は、あらかじめ固定の位置(球投影での角度)を与えています。

単純にキューブマップ面を合成しただけの場合は、 Ambient OcclusionやBloomの影響が大きいときに境界部分の切れ目が見えてしまいます。

これを解決するために、境界部にウエイト値を与えて補間することで境界が目立ちにくいようにします。

下画像の場合は、境界部分で+Z面に接する箇所はウエイト値が1.0に近づき、 -Y面に接する箇所は0.0に近づきます。

境界でない箇所はウエイト値を0.0としました。

境界部分では、+Z/-Y面がそれぞれ重なる箇所になるため、 +Z面上のピクセル色(col1)と-Y面上のピクセル色(col2)をあらかじめ取得できます。

ウエイト値をwとすると、以下の式で補正します。

float3 col = col2 * (1.0 - w) + col1 * w;

こうすることで、ある程度のPost Processingの境界部の色差を緩和できます。